Как сделать сайт в топе Яндекса?

Самостоятельное продвижение сайта в топ 10 Яндекса

Существует миф, что для получения дохода достаточно наличия только современного красивого сайта. В действительности этого оказывается мало. Ни один веб-ресурс не приведет новых клиентов, если на нем нет посетителей (целевого трафика). Продвижение сайта — неотъемлемая часть, обеспечивающая получение его владельцем доходов. Это как двигатель для автомобиля, обеспечивающий его движение. Поэтому важно уделить особое внимание к различным способам продвижения веб-сайта в интернете. В данной статье будет рассматриваться такая разновидность, как SEO.

Он представляет собой процесс оптимизации ресурса под поисковые системы, что обеспечивает высокие позиции в результатах выдачи. Чтобы этого добиться самостоятельно, понадобятся знания разметки веб-страниц (html), умения администрировать сайт, разрабатывать уникальный контент, а также навыки работы с веб-аналитикой. Это минимальная база, наличие которой является важным требованием при продвижении на поиске.

Многие владельцы сайтов хотят сэкономить на поисковом продвижении и приходят к решению осуществить данный процесс самостоятельно. При этом, изучив массу справочного материала по SEO, практически никто не представляет, какие «подводные камни» могут обнаружиться на практике. Реальность показывает, что почти в 90% случаев инициатива к самостоятельному продвижению сайта в поисковой выдаче полностью пропадает уже через несколько недель после начала работ. Причин несколько. В первую очередь, сказывается тот факт, что SEO — это процесс медленный. Для достижения хорошего результата в виде высокого ранга в выдаче, может понадобиться более 2-х месяцев. Для ниш с высоким уровнем конкуренции и вовсе этот срок измеряется годами. Готовы ли вы к столь долгому ожиданию результата?

Кроме того, поисковое продвижение требует комплексного подхода и регулярного анализа. Не получится сделать 2-3 действия и просто ждать. Только постоянно внося корректировки и улучшения, экспериментируя и изменяя функциональные элементы сайта можно добиться значительных результатов. По этой причине нужно заранее правильно оценивать свои возможности и силы. В таком направлении, как SEO, весомую роль играет усидчивость и чёткое следование к поставленной цели.

Другим фактором неудач в самостоятельном продвижении сайта является неготовность к переменам. Может потребоваться серьезная переработка веб-ресурса, вплоть до изменения дизайна и расширения стандартного функционала. Если вы не хотите что-то менять в сайте и вести постоянное его улучшение — значительного прогресса можно не ожидать. Будьте готовы к серьёзной работе, переработке структуры и изменениям с точки зрения «юзабилити» (удобства использования). Итак, поняв, что вы обладаете всеми необходимыми качествами и готовы к плотной работе, можно приступать к самостоятельному продвижению сайта в поисковой выдаче.

Семантическое ядро и кластеризация

Начать стоит со сбора семантического ядра — всех тех ключевых запросов, по которым интернет-пользователи должны находиться ваш веб-ресурс в результатах выдачи.

Для осуществления процесса потребуется воспользоваться таким ресурсом, как «Яндекс Вордстат». Нажав на кнопку «Все регионы», можно выставить интересующий регион.

Работа по сбору семантики сопровождается «мозговым штурмом» — перебором различных вариаций «ключевиков», построение ассоциаций. Использовать ключевые запросы лучше всего в виде сочетания фраз с различной частотностью показов (ВЧ, СЧ и НЧ). Для большего эффекта стоит уделить внимание ещё и истории запросов. Эта совокупность позволит выявить закономерности в сезонности, заранее предусмотреть колебания спроса.

Ускорить процесс можно, воспользовавшись специальными программами автоматизации, подробнее с которыми вы можете ознакомиться с помощью одной из нашей статьи в блоге. Но в случае, если у вас простой сайт и вы не обладаете практикой в сфере сбора «ключевиков», рекомендуется проделать операции вручную. Хоть это работа и более ропотливая, но позволяет понять всю суть данного процесса.

В процессе сбора ключей потребуется произвести и их распределение по страницам сайта. Данный процесс называется кластеризацией или группировкой. Объединять вместе нужно, исходя из тематичности смысловой близости фраз. Подсмотреть группировку в случае возникновения сомнений можно у конкурентов, задав определенный запрос и просмотрев первую десятку в выдаче. В случае использования автоматизированных программ и сервисов, данные действия произведутся автоматически.

Работа с аналитикой

Если у вас действующий сайт, обладающий определенной историей взаимодействия с посетителями, обязательно изучаем данные веб-аналитики, так как они и будут ключевым показателем результативности проделанных действий. Для молодых ресурсов, находящихся на начальном этапе своего существования (запуске), необходимо подключить аналитические системы. Лучше всего комплекс из «Яндекс Метрики» и «Гугл Аналитики». Так технически реализовано, что веб-аналитика от «Яндекса» с высокой достоверностью собирает сведения о переходах со своей поисковой системы, но предоставляет «размытую» информацию с других. Аналогичное можно сказать и про «Google». Если вы хотите добиться хороших результатов в выдачах обоих поисковиков, используйте сочетание, обобщая и анализируя информацию с обоих источников.

На какие данные аналитики нужно обращать внимание? Количество посетителей на сайте за определенный период (обычно берется от месяца и более, при сезонности бизнеса временной срез обязательно должен отражать рост и спад трафика, учитывать корреляцию). Другой важный показатель — источники переходов. Так вы сможете определить, каким образом посетители находят ваш веб-ресурс. Это могут быть социальные сети, контекстная реклама, карты, справочники, прямые заходы, другие веб-сайты, выдача поисковиков. С помощью этих сведений можно получить представление о движении трафика и выяснить, какие каналы приносят его в наибольшем количестве. Изучаем также данные об отказах, глубине просмотра, среднем времени, проведенном посетителями на сайте. Это позволит получить представление о поведении трафика.

Подробнее рассматриваем приходы посетителей из поисковой выдачи с раскладкой по запросам, которые вводили интернет-пользователи. Это поможет сделать предварительный прогноз на изменение объема трафика в последующие периоды при активизации работ по SEO.

Представленные показатели являются фундаментом, исходной отправной точкой. Можно изучать дополнительно и другие важные показатели, которые расширят представление о поведении посетителей и показателях эффективности веб-ресурса. Например, конверсию, количество достигнутых целей, используемых интернет-пользователями технологиях, страницы входа/выхода и т.д.

Техническая оптимизация и разметка страниц

Другая важная работа будет заключаться в технической оптимизации сайта. Для того, чтобы понять, какие проблемы присутствуют у веб-ресурса, можно воспользоваться данными «Яндекс Вебмастера» и сервисами, имеющими функционал для проведения технического аудита (например, «Топвизор»). В большинстве случаев, ошибки типовые: отсутствует файл robots.txt, нет карты сайта, пропущены «типовые поля» title, description, alt или заполнены неверно, не используются ЧПУ «URL». В более сложных случаях встречаются проблемы с запретом индексации со стороны системы администрирования. Это происходит в основном при использовании «самопальных» «CMS», в которых данная команда была прописана изначально при его «становлении», а по окончании работ по веб-ресурсу, ее никто и не вспомнил.

Точные проблемы веб-ресурса можно узнать только после проведения технического аудита. Обращаем также внимание на скорость загрузки веб-страниц, которая является ещё одним фактором, влияющим на ранжирование в естественной (органической) выдаче. Чтобы провести её оценку и выявить причины замедления, можно воспользоваться сервисом от «Google». Он произведет анализ, как скорости загрузки сайта на декстопе, так и мобильных телефонах, планшетах.

Разметка страниц подразумевает собой разбивку содержимого веб-сайта на основные единицы: заголовки (h1-h6), секции, абзацы, таблицы. При этом лучше всего такую разметку делать при помощи html-кода, а не обычного редактора. Это помогает поисковым систем точнее определять содержимое страниц. К примеру, заголовки являются для них маркерами, указывающими о том, чему будет посвящен тот или иной блок текста. Если их не добавить, то роботы «Яндекса» и «Гугла» будут разбивать текстовое содержимое на своё усмотрение, что может отличаться от ожиданий.

Написание контента

Ранее мы уже произвели сбор семантики и кластеризацию. Теперь на основании имеющейся информации нужно разработать контент — наполнение страниц сайта. Главные требования: текста должны быть уникальными (минимум 85%, лучше всего 100% по «Текст.ру»), заспамленность «ключами» не превышает допустимого поисковыми системами значения (60%). Объём контента должен быть достаточен для раскрытия информации, но ориентир стоит делать на конкурентов по выдаче на основании заданных ключей. В «Яндексе» ориентируйтесь на текст от 2 000 знаков без пробела, в «Google» — от 4000.

Графические материалы также желательно использовать свои уникальных, так как поисковые работы, осуществляющие анализ и индексирование веб-страниц сайта, обладают технологией машинного зрения. Таким образом, поисковикам не составит труда отличить фото, используемое на 20 различных сайтах и уникальное авторское. Предпочтение отдается второму.

Ещё один важный нюанс, который надо учесть, — это полезность контента для посетителя. Должен содержаться ответ на поставленный вопрос (запрос), раскрыты нюансы, описаны выгоды и преимущества. Не забываем про баланс между плотностью ключей и заспамленностью. Концентрация одного ключевого запроса не должна превышать 5%.

Перелинкова

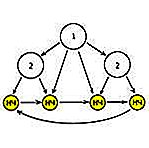

Работа относится к внутренней оптимизации. С помощью ссылок можно перераспределять веса между страницами. Чаще всего используется два варианты: иерархическая или циклическая перелинковка. Первый вариант представляет ссылки от нижестоящих страниц вышестоящим. Таким образом, придается больший вес разделам. Циклическая перелинковка представляет собой схему, при которой образуется цепочка ссылок (цикл), замыкающаяся в кольцо. Эффективность зависит от количества веб-страниц, входящих в цепную связь. Рекомендуется ссылаться с главной страницы на посадочные.

Также важно учитывать, что внутренних ссылок не должно быть слишком много. Оптимально 2-3 на один текст, но не более одной на 1000-1500 знаков в тексте (без пробелов).

Внешние ссылки

Несмотря на то, что данный фактор влияет на ранжирование с каждым годом все меньше, исключать его полностью нельзя. В умеренном количестве они благоприятно влияют на сайт. Главное не переборщить, иначе можно загнать веб-ресурс под фильтры поисковых систем. По этой причине наращивать ссылочную массу нужно постепенно, реагируя на изменения и следя за реакцией.

Закупать внешние ссылки стоит на специализированных площадках («GoGetLinks», «Miralinks», «RotaPost»), а ресурсы размещать стоит тематические, чтобы были схожи о нише и совпадали по целевой аудитории. Роль играет и последовательность расположения ссылок (нельзя чтобы шла подряд линковка на разные веб-сайты).

Уделяйте большее внимание внешним ссылкам «официальных» источникам – своей группе «Вконтакте» или других социальных сетях, «Яндекс картам» и «Справочнику» от Yandex и т. д.

Только в этом случае это даст свой положительный эффект.

Поведенческий фактор один из самых значимых. Оказывает наибольшее влияние на результаты ранжирования в поисковой выдаче прямым образом. Юзабилити или удобство веб-сайта играет ключевую роль. Ведь от того, на сколько легко пользоваться ресурсом зависит удовлетворенность посетителей и эффективность SEO в целом. Как узнать, что на сайте требует улучшения? В «Яндекс Метрике» есть такой встроенный инструмент, как «Вебвизор». С помощью него возможно наглядно просматривать поведение посетителей при взаимодействии с сайтом. Таким образом, можно выявить проблемные участки, доработав которые улучшится эффективность. Это положительно скажется на результатах выдачи и отдаче от веб-ресурса в целом.

И снова аналитика….

- Итак, начав работу по самостоятельному продвижению сайта, нужно постоянно работать с аналитикой. Кроме продуктов от «Яндекса» и «Google», обратить внимание стоит и на сервисы для сбора информации о занимаемых в выдаче позиций («Topvisor», «SiteAuditor» и т.п.). Они платные, но затраты будут зависеть лишь от количества запросов, которые необходимо проверить.

- Уделяем внимание при самостоятельном продвижении всем аспектам сразу – внутренней переработке сайта, проработке контента и его составляющих, внешних ссылок и т. д.

- При незнании определенных вопросов обращаемся к профильным специалистам за доработками или консультацией.

- Не забываем про организованную и понятную для человека структуру сайта, так как от нее, в первую очередь, будет зависеть поведенческий фактор.

И напоследок. Один из факторов, которому «Яндекс» уделяет очень сильный «интерес» — это отзывы об организации и рейтинг.

Повысить их можно различными способами, но никак не накруткой. Не получится добиться высокого рейтинга при накрутке отзывов при помощи фейковых аккаунтов! Почему? Читайте в соответствующей статье нашего блога.

Чат с компанией, выводящийся напрямую в поиске позволяет интернет-пользователю, не заходя на сайт, напрямую спросить о необходимой ему услуге/товаре. Так как «Яндекс» хранит историю сообщений, то на ее основе он и делает соответствующие выводы о вашей эффективности. О том, как его настроить и подключить тоже читайте в нашем блоге.

Внедряя все вышеперечисленные инструменты и своевременно анализируя их эффективность, вы сможете не только улучшить результаты поисковой выдачи, но и ощутить прибыль от проведенных операций и не зря потраченного времени.

akiwa.ru

7 простых способов вывести сайт в Топ поисковиков

Приветствую друзья. Как показали результаты опроса моих читателей — самая волнующая умы и сердца вебмастеров оказалась тема поискового продвижения сайта и seo приемчики. Оно и не удивительно, зачем мы создаем сайты в большинстве случаев? Верно, что бы зарабатывать с них.

Заработок с сайта напрямую зависит от количества посетителей, что в 99% случаев так же зависит от позиций сайта в поисковой выдаче.

Мало кто из нас желает покупать себе трафик в контекстной рекламе и других подобных инструментах — это очень дорого и подходит немногим. И даже те кому подходит все равно мечтают о халявном трафике =)

Так вот, сегодня я поделюсь с вами несколькими проверенными мной способами как вывести свой сайт на хорошие позиции в поисковиках. Они не дают 100% гарантий что вы сразу попадете в топ-3 Яндекса по вч ключам, но существенно повысят ваши шансы пробиться хотя бы на 1-ю страницу и определенно помогут улучшить позиции по ключевым запросам.

Для тех у кого нет времени или желания заниматься этим самостоятельно — я могу помочь с продвижением и оптимизацией сайтов. За подробностями пишите на емейл mail@ruskweb.ru

7 методов улучшить позиции сайта по ключам в Яндексе и Гугле

Для начала стоит определить основные моменты. Сайты мы продвигаем применяя некий комплекс мероприятий по поисковой оптимизации — то самое seo. Оно бывает внешнем и внутренним.

Внешняя оптимизация сайта это работа на стороне — закупка ссылок, всевозможные прогоны, статейное продвижение, различные сервисы и т.д. Как правило необходимы финансовые вливания.

Внутренняя оптимизация это соответственно работа на самом продвигаемом сайте, которая зачастую не требует вложений, нужны только знания и время.

Казалось бы, там где тратятся деньги и эффект должен быть больше. Но по моим наблюдениям решающую роль имеет именно внутренняя оптимизация сайта, внешняя лишь успешно дополняет, но не наоборот, поэтому ей я уделяю значительно больше внимания. Ну а теперь ближе к делу.

Способы продвижения сайта по ключам в поисковых системах

1. Уход за кодом сайта. Вы не представляете как много проектов, хороших, интересных, перспективных сайтов, страдает из-за того что люди не уделяют внимание техническим деталям. То, что не видно невооруженным глазом, но что определенно влияет на позиции сайта в выдаче. Если вы используете шаблон для вордпресса на своем сайте при этом никогда не заглядывали в его код, то будьте уверены — там сидит множество ошибок и недочетов, как незначительных, так и критических.

1. Уход за кодом сайта. Вы не представляете как много проектов, хороших, интересных, перспективных сайтов, страдает из-за того что люди не уделяют внимание техническим деталям. То, что не видно невооруженным глазом, но что определенно влияет на позиции сайта в выдаче. Если вы используете шаблон для вордпресса на своем сайте при этом никогда не заглядывали в его код, то будьте уверены — там сидит множество ошибок и недочетов, как незначительных, так и критических.

Из самых распространенных ошибок что встречались на моей практике:

- не валидный код. проверяется элементарно в валидаторе, не забывайте в настройках ставить html5 а то ужаснетесь количеству ошибок =)

- перегруженность скриптами, нерабочие или некорректно работающие скрипты

- некорректная или устаревшая верстка, ошибки верстки, кривые таблицы стилей

- нет адаптации для мобильных систем, что с недавних пор так же влияет на позиции сайтов в поиске

- неправильное расположение элементов в коде, например сайдбар в коде выше контента или нарушенная структура заголовков — теги H1-H6 используются где попало и как попало, на одной странице могут налепить по 3-4 заголовка H1 и т.д.

- долгая скорость загрузки, перегрузка тяжелыми элементами, скриптами, отсутствие плагинов кеширования и сжатия кода, использование тяжелых изображений или анимации, медленный хостинг и т.д. Вообще заметил что скорость загрузки сайта один из важнейших факторов для роста его посещаемости и позиций. Проверить насколько быстро грузится сайт можно инструментом гугла PageSpeed. Там же найдете и советы по оптимизации скорости загрузки

- вредоносные элементы — как в самом шаблоне так и в плагинах может сидеть вредоносный код, вирусы, скрытые ссылки, что может погубить проект на корню. Настоятельно рекомендую проверять шаблоны на всякую пакость спец. плагинами типа TAC и весь сайт антивирусными сервисами, типа AI-Bolit.

- неправильная настройка движка — отсутствие чпу, кириллические url’ы, replytocom’ы и прочее.

Все это может встречаться даже в самых дорогих и крутых шаблонах. Как правило шаблоны делаются для того что бы покупателю внешне все нравилось, было красиво и интересно, а вот как оно все работает изнутри мало кто задумывается при покупке.

2. Перелинковка. Это так называемые внутренние ссылки на страницах сайта, которые распределяют вес ссылочной массы по сайту и напитывают страницы анкорными ссылочками. За счет грамотной перелинковки можно неплохо улучшить свои позиции в выдаче, особенно по низкочастотным ключам. За счет неграмотной можно сделать только хуже.

2. Перелинковка. Это так называемые внутренние ссылки на страницах сайта, которые распределяют вес ссылочной массы по сайту и напитывают страницы анкорными ссылочками. За счет грамотной перелинковки можно неплохо улучшить свои позиции в выдаче, особенно по низкочастотным ключам. За счет неграмотной можно сделать только хуже.

Для небольших сайтов можно использовать ручной способ — проставлять 1-2 ссылочки в тексте статьи на похожие по тематике страницы . Для проектов со множеством страниц используются автоматизированные методы — это спец. плагины или самописные скрипты. Но даже в таком случае вручную добавленные ссылки будут не лишними- помимо прочего такие ссылки дают естественные переходы посетителей внутри сайта, что улучшает поведенческие факторы и так же благоприятно влияют на позиции. Работает сто процентов — проверено на данном блоге путем экспериментов с перелинковкой.

3. Оптимизация контента. Это непосредственная работа с текстом и изображениями. Пожалуй самый главный пункт. При создании контента важно понимать, что вы создаете его не только для поисковиков, или не только для читателей. Контент создается как для читателей, так и для поисковиков одновременно, это важно совмещать если вы хотите что бы страницы выходили на хорошие позиции.

3. Оптимизация контента. Это непосредственная работа с текстом и изображениями. Пожалуй самый главный пункт. При создании контента важно понимать, что вы создаете его не только для поисковиков, или не только для читателей. Контент создается как для читателей, так и для поисковиков одновременно, это важно совмещать если вы хотите что бы страницы выходили на хорошие позиции.

Иногда придется искать компромиссы, например заголовки статей, должны ли они цеплять читателя или должны в первую очередь сообщать поисковикам точную информацию о сути статьи?)

В тексте нужно использовать заголовки и подзаголовки, причем в правильном порядке. Нужно будет использовать списки и выделения. Нужно будет добавлять картинки иди видео. И много всего другого. Даже если вы считаете что все это не важно и будет только отвлекать внимание от вашей гениальной писанины, все равно придется =)

Не стоит забывать и про технические детали — контент должен быть уникальный и качественный, без ошибок и по существу, размеры текста не менее 1500-2000 знаков, грамотное внедрение ключевых слов без переспама, с использованием синонимов и разбавлением, правильная релевантность текста заголовкам и ключам, использование сео плагинов для прописывание тегов title и description как самому тексту, так и картинками т.д. Страницы должны легко читаться, самое важное на странице должно быть как-то выделено ( заголовки, размер шрифта, жирный шрифт, подчеркивания, графические элементы, картинки и т.д. ), что бы глаз цеплялся не позволяя посетителю уплыть на другие сайты.

4. Robotsы, чпу и карты сайта. С картами сайта все понятна — установил плагин Google xml sitemaps и он все сам будет делать за вас. Карту для посетителей тоже недолго сделать. С ЧПУ тоже ясно — скопировал вставил и вот у нас уже ссылки содержат в себе какую-то семантику а не случайный набор цифр и букв. А вот с robots.txt не все так однозначно. Первым делом этот файлик нужен для борьбы с ненужным дублирующим контентом, которого в вордпрессе предостаточно. Но вы не можете просто скопировать готовый роботс с другого сайта и быть на 100% уверенным что он будет работать у вас как надо. Это все равно что выдавать всем людям одежду одного размера — на ком-то будет висеть, на кого-то не налезет.

4. Robotsы, чпу и карты сайта. С картами сайта все понятна — установил плагин Google xml sitemaps и он все сам будет делать за вас. Карту для посетителей тоже недолго сделать. С ЧПУ тоже ясно — скопировал вставил и вот у нас уже ссылки содержат в себе какую-то семантику а не случайный набор цифр и букв. А вот с robots.txt не все так однозначно. Первым делом этот файлик нужен для борьбы с ненужным дублирующим контентом, которого в вордпрессе предостаточно. Но вы не можете просто скопировать готовый роботс с другого сайта и быть на 100% уверенным что он будет работать у вас как надо. Это все равно что выдавать всем людям одежду одного размера — на ком-то будет висеть, на кого-то не налезет.

Почему так происходит? Потому что правильная настройка роботса зависит от многих факторов — от того какой у вас шаблон, как настроены ЧПУ, какая внутренняя структура у сайта и уровень вложенности страниц с контентом, будет ли уникальный контент на страницах архивов и каталогов или нет, используются ли тэги, как вы настроили перелинковку, вплоть до отдельных плагинов которые тоже придется учитывать.

Важно настроить его так, что бы исключить весь дублирующий контент, при этом не зацепить ничего лишнего — не закрывать от индексации то, что должно попасть в поисковики. Это касается не только текстов, но и элементов оформления страниц и скриптов отвечающих за настройку структуры страницы. Для правильной настройки можно использовать отличный интрумент — гугл для вебмастеров, Посмотреть как Google-bot. Там вам покажут как видит ваш сайт поисковик, и ниже приведут список заблокированных элементов на странице. Кстати там же можно отправлять свежие страницы в индекс Гугла одним кликом.

Я однажды посмотрел на свой сайт глазами робота, ужаснулся и включил таблицы стилей в списки robots.txt разрешенных для индексации. На одном из молодых сайтов после этого трафик увеличился с 20-30 чел в сутки до 100+ буквально через пару недель. Постарайтесь сделать так, что бы поисковый робот видел ваш сайт таким, как его видят обычные посетители, при этом заблокировав все лишнее. Для этого может потребоваться вручную подключать каждый скрипт вплоть до файлов отдельных плагинов, что бы не дать случайно доступ роботу к дублям.

5. Социальное продвижение. Еще пару лет назад почти никто не обращал внимание на соц. сигналы в сфере продвижения, поисковики нейтрально относились к количеству твитов и лайков на страничках. Однако все меняется, сегодня соц. сигналы оказывают непосредственное влияние на позиции страниц в выдаче. Кроме того соц. сети это перспективный источник большого трафика для многих тематик.

5. Социальное продвижение. Еще пару лет назад почти никто не обращал внимание на соц. сигналы в сфере продвижения, поисковики нейтрально относились к количеству твитов и лайков на страничках. Однако все меняется, сегодня соц. сигналы оказывают непосредственное влияние на позиции страниц в выдаче. Кроме того соц. сети это перспективный источник большого трафика для многих тематик.

Откуда же брать твиты и лайки? Для начала конечно необходимо установить соц. кнопки на страницах вашего сайта. Для этого существует множество сервисов и плагинов, я свой выбор остановил на кнопках от Яндекса https://tech.yandex.ru/share/. По крайней мере могу быть уверен что статистика не уплывет куда-то на сторону, да и грузится блок довольно быстро.

Кроме того, если вы расчитываете на соц. продвижение то необходимо создать представительство вашего сайта во всех популярных соц. сетях, проще говоря создать группы вконтакте, фейсбуке, завести рабочий твиттер, может даже создать канал на ютубе. И заниматься их развитием, добавлять интересный контент, устраивать конкурсы, точно так же заниматься раскруткой и набором подписчиков. На первых порах могут помочь сервисы, типа soclike и подобных, которые за денежку позволяют покупать ретвиты, подписчиков, или публикации на стены ваших новостей и ссылок.

Вебмастерам придется задумываться о контенте, который будет в первую очередь интересен именно пользователям соц. сетей, хотя бы иногда.

6. Cсылочная масса. Да-да, на дворе шел 2019 год а ссылки по прежнему работают, вопреки всем утверждениям новых алгоритмов Яндекса и прогнозам сеошников в течении последних лет эдак 10. Но есть одно большое НО. Работают только естественные ссылки или очень похожие на них =) Т.е. ссылки размещенные в статьях и комментариях, ссылки безанкорные или с анкорами «здесь», «тут», «на этом сайте» и т.д., ссылки по которым есть реальные переходы заинтересованных посетителей, ссылки тематические и размещенные в статьях со схожей тематикой на трастовых ресурсах.

6. Cсылочная масса. Да-да, на дворе шел 2019 год а ссылки по прежнему работают, вопреки всем утверждениям новых алгоритмов Яндекса и прогнозам сеошников в течении последних лет эдак 10. Но есть одно большое НО. Работают только естественные ссылки или очень похожие на них =) Т.е. ссылки размещенные в статьях и комментариях, ссылки безанкорные или с анкорами «здесь», «тут», «на этом сайте» и т.д., ссылки по которым есть реальные переходы заинтересованных посетителей, ссылки тематические и размещенные в статьях со схожей тематикой на трастовых ресурсах.

Те же ссылки которые ставятся на ваш сайт со ссылкопомоек, переспамленных страниц и сайтов с активной продажной позицией =), ссылки размещенные где-то внизу страниц или даже в футере, по которым никто и никогда не кликнет, а если и кликнет то случайно и сразу же закроет страницу и т.д. все это только поспособствует лишь наложению определенных санкций от поисковых систем, а вовсе не килотоннам трафика. От таких ссылок, если они имеются, нужно как можно скорей избавляться.

Где брать такие хорошие качественные и естественные ссылки? Вопрос на миллион =) Самый лучший способ это помогать другим людям решать их проблемы, написать качественную, развернутую и полезную статью, которая даст ответы на их вопросы. Тогда велик шанс что рано или поздно кто-то поделиться этой информацией с другими оставив ссылку на ваш ресурс. Или же другие сайты оценят ваш контент и будут копировать его к себе, оставляя обратные ссылки на источник — это тоже неплохо работает.

Это так же могут быть ваши гостевые статьи на других сайтах с вашей обратной ссылкой.

Ну и конечно же их можно купить. Если надумаете покупать то рекомендую не мелочиться и заказывать сразу размещение вашей статьи с ссылками, эффект будет намного лучше.

Другое дело что хорошие ссылки и стоят хорошо, кроме того нужно уметь правильно выбирать доноров для покупки, иначе за свои же деньги купите себе фильтр. Я лично пользуюсь старым добрым GGL для поиска и покупки ссылок на нормальных площадках.

Неплохой вариант для внешнего продвижения — воспользоваться услугами сеошников на бирже Кворк. Там за 500 рублей можно найти нормальные варианты ссылочных профилей и прогонов.

7. Юзабилити. Наши сайты перегружены массой ненужных элементов, непонятной рекламой, которая не работает и особо не приносит дохода, всякими слайдерами, на которые никто не обращает внимания, всевозможными украшалочками или ссылками по которым никто никогда не кликает, страницами и баннерами, которые никому не нужны, плагинами, без которых можно легко обойтись или их можно заменить одной строчкой кода и еще кучей всякого виртуального хлама. Все что не работает должно исчезнуть. Все сложное должно быть упрощено. Избавившись от лишнего кода и ненужных элементов вы ускорите загрузку сайта и уменьшите вероятность ошибок и проблем в этих местах.

7. Юзабилити. Наши сайты перегружены массой ненужных элементов, непонятной рекламой, которая не работает и особо не приносит дохода, всякими слайдерами, на которые никто не обращает внимания, всевозможными украшалочками или ссылками по которым никто никогда не кликает, страницами и баннерами, которые никому не нужны, плагинами, без которых можно легко обойтись или их можно заменить одной строчкой кода и еще кучей всякого виртуального хлама. Все что не работает должно исчезнуть. Все сложное должно быть упрощено. Избавившись от лишнего кода и ненужных элементов вы ускорите загрузку сайта и уменьшите вероятность ошибок и проблем в этих местах.

Пользователь должен в пару кликов достигать основной цели — вашей цели, то ради чего вы привлекаете его на свой сайт. Если ему что-то мешает или отвлекает от этой цели значит это лишнее.

В этом плане очень хорошо помогает инструмент Вебвизор, аналитка форм, карта кликов в Яндекс. метрике. Проанализируйте поведение пользователей на вашем сайте, найдите слабые места и устраните их. Это поможет улучшить и конверсию и поведенческие факторы, что благоприятно скажется на позициях в выдаче.

Например, вам может казаться что картинка на пол экрана это красиво и очень нравится посетителям, или что вам обязательно нужен слайдер на главной странице, или что без этого видео в сайдбаре все заплюют ваш ресурс и скажут что он уже не тот что был раньше. Но реальную картину вы сможете получить только после экспериментов — замерьте в метрике поведенческие факторы, посмотрите время пребывание на странице, показатели отказов, количество внутренних переходов. Затем удалите и понаблюдайте как изменятся ПФ в течении недели. Если пф не поменялись или даже выросли то можете смело удалять элемент. Если они ухудшились то возвращаем как было и пробуем что-то другое.

И только после того, как избавитесь от всего лишнего и удалять уже будет нечего, можно подумать о том, что бы что-то добавить. Все по той же схеме — с проверкой эффективности в метрике.

Вы можете заметить, что это далеко не все способы улучшить позиции сайта в поисковой выдаче, вспомните про накрутку поведенческих факторов, про покупку трафика, про какие-нибудь прогоны по трастовым сайтам, про ответы на форумах, про сслылки в профилях, про каталоги статей, сателлиты и т.д. и т.п. Но все это частные случаи, либо уже почти не работает, либо строго карается как манипуляции с поведенческими факторами например. Я постарался перечислить лишь самые главные и до сих пор актуальные методы поискового продвижения.

ruskweb.ru